|

1. RAC环境信息 4 1.1. IP地址信息 4 2. 环境备份 5 2.1. $ORACLE_HOME备份 5 2.2. $CRS_HOME备份 5 2.3. OCR备份 5 2.4. VoteDisk备份 6 2.5. 主机脚本备份 6 3. 删除数据库实例 8 3.1. 启动vnc服务 8 3.2. 在原有节点(nmacct1)执行dbca 8 3.3. 选择实例管理 9 3.4. 选择删除实例 10 3.5. 输入sysdba用户和口令 11 3.6. 选择需要删除的实例 12 3.7. 确认删除实例 13 3.8. 查看CRS状态 14 4. 删除数据库监听 16 4.1. 查看当前监听状态 16 4.2. 在被删除节点执行netca 16 4.3. 选择需要删除监听的节点 17 4.4. 选择监听配置方式 17 4.5. 选择删除操作 18 4.6. 确认删除操作 19 4.7. 完成删除操作 19 4.8. 查看当前监听状态 20 5. 删除数据库软件 22 5.1. 在删除节点执行runInstaller脚本,指定为本地方式 22 5.2. 在删除节点执行不带参数的runInstaller脚本,启动oui 22 5.3. 选择删除软件为数据库软件 24 5.4. 执行删除过程 26 5.5. 完成删除 27 5.6. 在保留任意节点执行runInstaller更新节点信息 28 6. 删除ONS服务 29 6.1. 查看集群状态 29 6.2. 查看ONS配置 29 6.3. 使用racgons命令完成删除 29 6.4. 查看集群信息 30 7. 删除数据库集群 31 7.1. 查看集群状态 31 7.2. 在被删除节点执行rootdelete.sh 31 7.3. 在其他节点执行rootdeletenode.sh 32 7.3.1. 查看集群节点信息 32 7.3.2. 删除节点信息 (root用户) 32 7.4. 查看集群状态 32 7.4.1. 被删除节点 32 7.4.2. 其他节点 33 8. 删除集群软件 34 8.1. 在删除节点执行runInstaller脚本,指定为本地方式 34 8.2. 在删除节点执行不带参数的runInstaller脚本,启动oui 34 8.3. 选择删除软件为集群软件 36 8.4. 执行删除过程 37 8.5. 在保留任意节点节点执行runInstaller更新节点信息 39 8.6. 被删除节点清理软件目录 (使用root用户) 39 9. 清理主机环境 40 9.1. 清理hosts文件 40 9.1.1. 磁盘信息 40 9.1.2. 扫描lv (所有节点) 40 9.1.3. 绑定裸设备 (所有节点都需要操作) 42 9.1.4. 修改裸设备权限 46 9.1.5. 修改启动文件使权限永久生效 46 9.2. 删除authorized_keys文件中删除节点的信息 47 1. RAC环境信息1.1. IP地址信息127.0.0.1 localhost 192.168.56.111 nmacct1 192.168.56.112 nmacct1-vip 192.168.56.121 nmacct2 192.168.56.122 nmacct2-vip 192.168.56.131 nmacct3 192.168.56.132 nmacct3-vip 10.10.10.11 nmacct1-priv 10.10.10.12 nmacct2-priv 10.10.10.13 nmacct3-priv 2. 环境备份2.1. $ORACLE_HOME备份[oracle@nmacct1 ~]$ tar cvf db.tar /oracle/product/10.2.0/db/ tar: Removing leading `/' from member names /oracle/product/10.2.0/db/ /oracle/product/10.2.0/db/wwg/ /oracle/product/10.2.0/db/wwg/admin/ /oracle/product/10.2.0/db/wwg/admin/images/ 2.2. $CRS_HOME备份[oracle@nmacct1 ~]$ tar cvf crs.tar /oracle/product/10.2.0/crs/ tar: Removing leading `/' from member names /oracle/product/10.2.0/crs/ /oracle/product/10.2.0/crs/sysman/ /oracle/product/10.2.0/crs/sysman/lib32/ 2.3. OCR备份[oracle@nmacct1 ~]$ ocrcheck Status of Oracle Cluster Registry is as follows : Version : 2 Total space (kbytes) : 204576 Used space (kbytes) : 4608 Available space (kbytes) : 199968 ID : 96694627 Device/File Name : /dev/raw/raw1 Device/File integrity check succeeded Device/File Name : /dev/raw/raw2 Device/File integrity check succeeded Cluster registry integrity check succeeded [oracle@nmacct3 ~]$ dd if=/dev/raw/raw1 of=/home/oracle/ocr.bak 409600+0 records in 409600+0 records out 209715200 bytes (210 MB) copied, 66.1798 seconds, 3.2 MB/s 2.4. VoteDisk备份[oracle@nmacct1 ~]$ crsctl query css votedisk 0. 0 /dev/raw/raw3 1. 0 /dev/raw/raw4 2. 0 /dev/raw/raw5 located 3 votedisk(s). [oracle@nmacct1 ~]$ dd if=/dev/raw/raw3 of=/home/oracle/votedisk.bak 409600+0 records in 409600+0 records out 209715200 bytes (210 MB) copied, 66.3791 seconds, 3.2 MB/s 2.5. 主机脚本备份For Sun:

/etc/init.d/init.cssd

/etc/init.d/init.crs

/etc/init.d/init.crsd

/etc/init.d/init.evmd

/var/opt/oracle

/etc/inittab

For Linux:

/etc/init.d/init.cssd

/etc/init.d/init.crs

/etc/init.d/init.crsd

/etc/init.d/init.evmd

/etc/oracle

/etc/inittab

For HP-UX:

/sbin/init.d/init.cssd

/sbin/init.d/init.crs

/sbin/init.d/init.crsd

/sbin/init.d/init.evmd

/var/opt/oracle

/etc/inittab

For HP Tru64:

/sbin/init.d/init.cssd

/sbin/init.d/init.crs

/sbin/init.d/init.crsd

/sbin/init.d/init.evmd

/var/opt/oracle

/etc/inittab

For IBM AIX:

/etc/init.cssd

/etc/init.crs

/etc/init.crsd

/etc/init.evmd

/etc/oracle

/etc/inittab 参考文档:10gR2/11gR1: What Files To Backup In Oracle Clusterware (CRS) Installation [ID 754369.1] 3. 删除数据库实例3.1. 启动vnc服务[oracle@nmacct1 ~]$ vncserver :1 New 'nmacct1:1 (oracle)' desktop is nmacct1:1 Starting applications specified in /home/oracle/.vnc/xstartup Log file is /home/oracle/.vnc/nmacct1:1.log 3.2. 在原有节点(nmacct1)执行dbca[oracle@nmacct1 ~]$ dbca

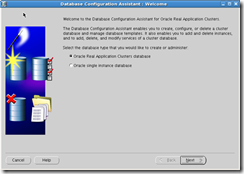

3.3. 选择实例管理

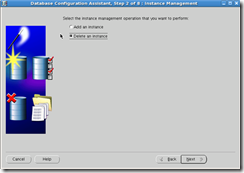

3.4. 选择删除实例

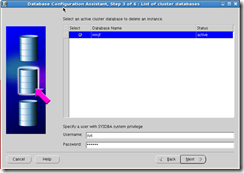

3.5. 输入sysdba用户和口令

3.6. 选择需要删除的实例

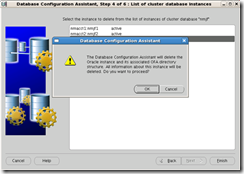

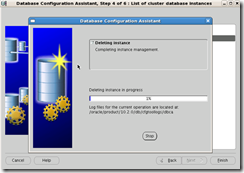

3.7. 确认删除实例

3.8. 查看CRS状态[oracle@nmacct1 ~]$ crs_stat -t Name Type Target State Host ------------------------------------------------------------ ora....T1.lsnr application ONLINE ONLINE nmacct1 ora....ct1.gsd application ONLINE ONLINE nmacct1 ora....ct1.ons application ONLINE ONLINE nmacct1 ora....ct1.vip application ONLINE ONLINE nmacct1 ora....T2.lsnr application ONLINE ONLINE nmacct2 ora....ct2.gsd application ONLINE ONLINE nmacct2 ora....ct2.ons application ONLINE ONLINE nmacct2 ora....ct2.vip application ONLINE ONLINE nmacct2 ora....T3.lsnr application ONLINE ONLINE nmacct3 ora....ct3.gsd application ONLINE ONLINE nmacct3 ora....ct3.ons application ONLINE ONLINE nmacct3 ora....ct3.vip application ONLINE ONLINE nmacct3 ora.nmjf.db application ONLINE ONLINE nmacct2 ora....f1.inst application ONLINE ONLINE nmacct1 ora....f2.inst application ONLINE ONLINE nmacct2 [oracle@nmacct1 ~]$ crs_stat | grep inst NAME=ora.nmjf.nmjf1.inst NAME=ora.nmjf.nmjf2.inst 已经没有实例3的信息。 4. 删除数据库监听4.1. 查看当前监听状态[oracle@nmacct1 ~]$ crs_stat -t Name Type Target State Host ------------------------------------------------------------ ora....T1.lsnr application ONLINE ONLINE nmacct1 ora....ct1.gsd application ONLINE ONLINE nmacct1 ora....ct1.ons application ONLINE ONLINE nmacct1 ora....ct1.vip application ONLINE ONLINE nmacct1 ora....T2.lsnr application ONLINE ONLINE nmacct2 ora....ct2.gsd application ONLINE ONLINE nmacct2 ora....ct2.ons application ONLINE ONLINE nmacct2 ora....ct2.vip application ONLINE ONLINE nmacct2 ora....T3.lsnr application ONLINE ONLINE nmacct3 ora....ct3.gsd application ONLINE ONLINE nmacct3 ora....ct3.ons application ONLINE ONLINE nmacct3 ora....ct3.vip application ONLINE ONLINE nmacct3 ora.nmjf.db application ONLINE ONLINE nmacct2 ora....f1.inst application ONLINE ONLINE nmacct1 ora....f2.inst application ONLINE ONLINE nmacct2 4.2. 在被删除节点执行netca[oracle@nmacct3 ~]$ netca Oracle Net Services Configuration:

4.3. 选择需要删除监听的节点

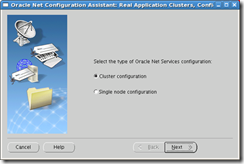

4.4. 选择监听配置方式

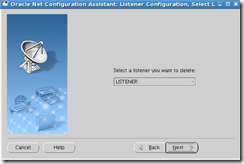

4.5. 选择删除操作

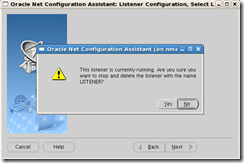

4.6. 确认删除操作

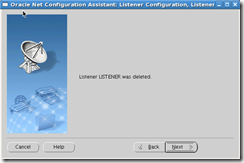

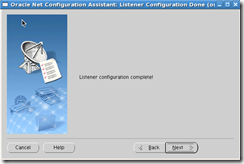

4.7. 完成删除操作

4.8. 查看当前监听状态[oracle@nmacct1 ~]$ crs_stat -t Name Type Target State Host ------------------------------------------------------------ ora....T1.lsnr application ONLINE ONLINE nmacct1 ora....ct1.gsd application ONLINE ONLINE nmacct1 ora....ct1.ons application ONLINE ONLINE nmacct1 ora....ct1.vip application ONLINE ONLINE nmacct1 ora....T2.lsnr application ONLINE ONLINE nmacct2 ora....ct2.gsd application ONLINE ONLINE nmacct2 ora....ct2.ons application ONLINE ONLINE nmacct2 ora....ct2.vip application ONLINE ONLINE nmacct2 ora....ct3.gsd application ONLINE ONLINE nmacct3 ora....ct3.ons application ONLINE ONLINE nmacct3 ora....ct3.vip application ONLINE ONLINE nmacct3 ora.nmjf.db application ONLINE ONLINE nmacct2 ora....f1.inst application ONLINE ONLINE nmacct1 ora....f2.inst application ONLINE ONLINE nmacct2 [oracle@nmacct1 ~]$ crs_stat | grep lsnr NAME=ora.nmacct1.LISTENER_NMACCT1.lsnr NAME=ora.nmacct2.LISTENER_NMACCT2.lsnr 5. 删除数据库软件5.1. 在删除节点执行runInstaller脚本,指定为本地方式./runInstaller -updateNodeList ORACLE_HOME=Oracle_home "CLUSTER_NODES={node_name}" –local [oracle@nmacct3 ~]$ cd $ORACLE_HOME/oui/bin [oracle@nmacct3 bin]$ ./runInstaller -updateNodeList ORACLE_HOME=$ORACLE_HOME "C LUSTER_NODES=nmacct3" -local Starting Oracle Universal Installer... No pre-requisite checks found in oraparam.ini, no system pre-requisite checks wi ll be executed. The inventory pointer is located at /etc/oraInst.loc The inventory is located at /oracle/oraInventory 'UpdateNodeList' was successful. 5.2. 在删除节点执行不带参数的runInstaller脚本,启动oui[oracle@nmacct3 bin]$ ./runInstaller Starting Oracle Universal Installer... No pre-requisite checks found in oraparam.ini, no system pre-requisite checks will be executed. Preparing to launch Oracle Universal Installer from /tmp/OraInstall2013-07-18_10-44-16AM. Please wait ...

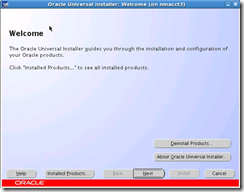

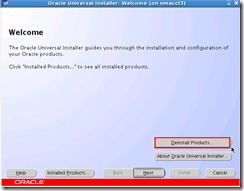

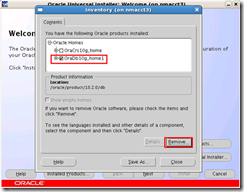

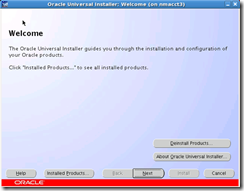

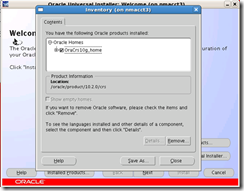

5.3. 选择删除软件为数据库软件

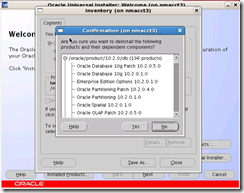

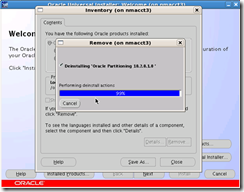

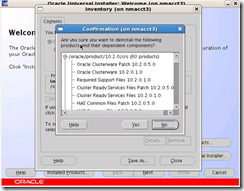

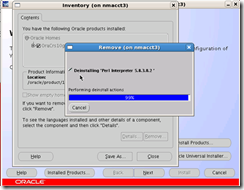

5.4. 执行删除过程

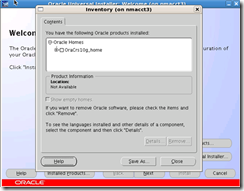

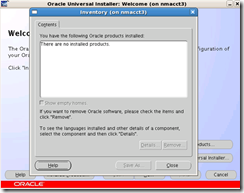

5.5. 完成删除

5.6. 在保留任意节点执行runInstaller更新节点信息./runInstaller -updateNodeList ORACLE_HOME=Oracle_home "CLUSTER_NODES={remaining_nodes_list}" [oracle@nmacct1 ~]$ cd $ORACLE_HOME/oui/bin [oracle@nmacct1 bin]$ ./runInstaller -updateNodeList ORACLE_HOME=$ORACLE_HOME "CLUSTER_NODES=nmacct1,nmacct2" Starting Oracle Universal Installer... No pre-requisite checks found in oraparam.ini, no system pre-requisite checks will be executed. The inventory pointer is located at /etc/oraInst.loc The inventory is located at /oracle/oraInventory 'UpdateNodeList' was successful. 6. 删除ONS服务6.1. 查看集群状态[oracle@nmacct3 ~]$ crs_stat -t Name Type Target State Host ------------------------------------------------------------ ora....T1.lsnr application ONLINE ONLINE nmacct1 ora....ct1.gsd application ONLINE ONLINE nmacct1 ora....ct1.ons application ONLINE ONLINE nmacct1 ora....ct1.vip application ONLINE ONLINE nmacct1 ora....T2.lsnr application ONLINE ONLINE nmacct2 ora....ct2.gsd application ONLINE ONLINE nmacct2 ora....ct2.ons application ONLINE ONLINE nmacct2 ora....ct2.vip application ONLINE ONLINE nmacct2 ora....ct3.gsd application ONLINE ONLINE nmacct3 ora....ct3.ons application ONLINE ONLINE nmacct3 ora....ct3.vip application ONLINE ONLINE nmacct3 ora.nmjf.db application ONLINE ONLINE nmacct2 ora....f1.inst application ONLINE ONLINE nmacct1 ora....f2.inst application ONLINE ONLINE nmacct2 6.2. 查看ONS配置[oracle@nmacct3 ~]$ more $CRS_HOME/opmn/conf/ons.config localport=6113 remoteport=6200 loglevel=3 useocr=on 6.3. 使用racgons命令完成删除[oracle@nmacct3 ~]$ $CRS_HOME/bin/racgons remove_config nmacct3:6200 racgons: Existing key value on nmacct3 = 6200. racgons: nmacct3:6200 removed from OCR. 6.4. 查看集群信息[oracle@nmacct3 ~]$ crs_stat -t Name Type Target State Host ------------------------------------------------------------ ora....T1.lsnr application ONLINE ONLINE nmacct1 ora....ct1.gsd application ONLINE ONLINE nmacct1 ora....ct1.ons application ONLINE ONLINE nmacct1 ora....ct1.vip application ONLINE ONLINE nmacct1 ora....T2.lsnr application ONLINE ONLINE nmacct2 ora....ct2.gsd application ONLINE ONLINE nmacct2 ora....ct2.ons application ONLINE ONLINE nmacct2 ora....ct2.vip application ONLINE ONLINE nmacct2 ora....ct3.gsd application ONLINE ONLINE nmacct3 ora....ct3.ons application ONLINE ONLINE nmacct3 ora....ct3.vip application ONLINE ONLINE nmacct3 ora.nmjf.db application ONLINE ONLINE nmacct2 ora....f1.inst application ONLINE ONLINE nmacct1 ora....f2.inst application ONLINE ONLINE nmacct2 此时获得的状态与ONS删除之前显示状态相同。因为此时并未影响到集群的状态。 7. 删除数据库集群7.1. 查看集群状态[oracle@nmacct3 ~]$ crs_stat -t Name Type Target State Host ------------------------------------------------------------ ora....T1.lsnr application ONLINE ONLINE nmacct1 ora....ct1.gsd application ONLINE ONLINE nmacct1 ora....ct1.ons application ONLINE ONLINE nmacct1 ora....ct1.vip application ONLINE ONLINE nmacct1 ora....T2.lsnr application ONLINE ONLINE nmacct2 ora....ct2.gsd application ONLINE ONLINE nmacct2 ora....ct2.ons application ONLINE ONLINE nmacct2 ora....ct2.vip application ONLINE ONLINE nmacct2 ora....ct3.gsd application ONLINE ONLINE nmacct3 ora....ct3.ons application ONLINE ONLINE nmacct3 ora....ct3.vip application ONLINE ONLINE nmacct3 ora.nmjf.db application ONLINE ONLINE nmacct2 ora....f1.inst application ONLINE ONLINE nmacct1 ora....f2.inst application ONLINE ONLINE nmacct2 7.2. 在被删除节点执行rootdelete.sh[iyunv@nmacct3 ~]# cd $CRS_HOME [iyunv@nmacct3 crs]# cd install [iyunv@nmacct3 install]# ./rootdelete.sh Shutting down Oracle Cluster Ready Services (CRS): Jul 18 11:02:21.787 | INF | daemon shutting down Stopping resources. This could take several minutes. Successfully stopped CRS resources. Stopping CSSD. Shutting down CSS daemon. Shutdown request successfully issued. Shutdown has begun. The daemons should exit soon. Checking to see if Oracle CRS stack is down... Oracle CRS stack is not running. Oracle CRS stack is down now. Removing script for Oracle Cluster Ready services Updating ocr file for downgrade Cleaning up SCR settings in '/etc/oracle/scls_scr' Cleaning up Network socket directories 7.3. 在其他节点执行rootdeletenode.sh7.3.1. 查看集群节点信息[oracle@nmacct1 ~]$ cd $CRS_HOME/bin [oracle@nmacct1 bin]$ ./olsnodes -n nmacct1 1 nmacct2 2 nmacct3 3 7.3.2. 删除节点信息 (root用户)[iyunv@nmacct1 ~]# cd $CRS_HOME/install [iyunv@nmacct1 install]# ./rootdeletenode.sh nmacct3, 3 CRS nodeapps are deleted successfully clscfg: EXISTING configuration version 3 detected. clscfg: version 3 is 10G Release 2. Node deletion operation successful. 'nmacct3' deleted successfully 7.4. 查看集群状态7.4.1. 被删除节点[oracle@nmacct3 ~]$ crs_stat -t CRS-0184: Cannot communicate with the CRS daemon. CRS进程已经无法通信。 7.4.2. 其他节点[oracle@nmacct1 install]$ crs_stat -t Name Type Target State Host ------------------------------------------------------------ ora....T1.lsnr application ONLINE ONLINE nmacct1 ora....ct1.gsd application ONLINE ONLINE nmacct1 ora....ct1.ons application ONLINE ONLINE nmacct1 ora....ct1.vip application ONLINE ONLINE nmacct1 ora....T2.lsnr application ONLINE ONLINE nmacct2 ora....ct2.gsd application ONLINE ONLINE nmacct2 ora....ct2.ons application ONLINE ONLINE nmacct2 ora....ct2.vip application ONLINE ONLINE nmacct2 ora.nmjf.db application ONLINE ONLINE nmacct2 ora....f1.inst application ONLINE ONLINE nmacct1 ora....f2.inst application ONLINE ONLINE nmacct2 已经没有被删除节点信息。 8. 删除集群软件8.1. 在删除节点执行runInstaller脚本,指定为本地方式./runInstaller -updateNodeList ORACLE_HOME=CRS_home "CLUSTER_NODES={node_to_be_deleted}" CRS=TRUE -local [oracle@nmacct3 ~]$ cd $CRS_HOME/oui/bin [oracle@nmacct3 bin]$ ./runInstaller -updateNodeList ORACLE_HOME=$CRS_HOME "CLUSTER_NODES=nmacct3" CRS=TRUE -local Starting Oracle Universal Installer... No pre-requisite checks found in oraparam.ini, no system pre-requisite checks will be executed. The inventory pointer is located at /etc/oraInst.loc The inventory is located at /oracle/oraInventory 'UpdateNodeList' was successful. 8.2. 在删除节点执行不带参数的runInstaller脚本,启动oui[oracle@nmacct3 ~]$ cd $CRS_HOME/oui/bin [oracle@nmacct3 bin]$ ./runInstaller Starting Oracle Universal Installer... No pre-requisite checks found in oraparam.ini, no system pre-requisite checks will be executed. Preparing to launch Oracle Universal Installer from /tmp/OraInstall2013-07-18_11-17-29AM. Please wait ...[oracle@nmacct3 bin]$ Oracle Universal Installer, Version 10.2.0.5.0 Production Copyright (C) 1999, 2010, Oracle. All rights reserved.

8.3. 选择删除软件为集群软件

8.4. 执行删除过程

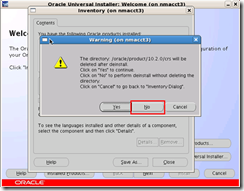

选择No防止$CRS_HOME目录被删除。

8.5. 在保留任意节点节点执行runInstaller更新节点信息./runInstaller -updateNodeList ORACLE_HOME=CRS_home "CLUSTER_NODES={remaining_nodes_list}" CRS=TRUE [oracle@nmacct1 ~]$ cd $CRS_HOME/oui/bin [oracle@nmacct1 bin]$ ./runInstaller -updateNodeList ORACLE_HOME=$CRS_HOME "CLUSTER_NODES=nmacct1,nmacct2" CRS=TRUE Starting Oracle Universal Installer... No pre-requisite checks found in oraparam.ini, no system pre-requisite checks will be executed. The inventory pointer is located at /etc/oraInst.loc The inventory is located at /oracle/oraInventory 'UpdateNodeList' was successful. 8.6. 被删除节点清理软件目录 (使用root用户)[iyunv@nmacct3 ~]# rm -rf $ORACLE_HOME [iyunv@nmacct3 ~]# rm -rf $CRS_HOME 9. 清理主机环境9.1. 清理hosts文件9.1.1. 磁盘信息[iyunv@nmacct3 ~]# ls -la /dev/sd* brw-r----- 1 root disk 8, 0 Jul 17 16:10 /dev/sda brw-r----- 1 root disk 8, 1 Jul 17 16:11 /dev/sda1 brw-r----- 1 root disk 8, 2 Jul 17 16:10 /dev/sda2 brw-r----- 1 root disk 8, 16 Jul 17 16:10 /dev/sdb brw-r----- 1 root disk 8, 32 Jul 17 16:10 /dev/sdc brw-r----- 1 root disk 8, 48 Jul 17 16:10 /dev/sdd 9.1.2. 扫描lv (所有节点)[iyunv@nmacct2 ~]# lvscan ACTIVE '/dev/share_vg/ocr1' [200.00 MB] inherit ACTIVE '/dev/share_vg/ocr2' [200.00 MB] inherit ACTIVE '/dev/share_vg/voting1' [200.00 MB] inherit ACTIVE '/dev/share_vg/voting2' [200.00 MB] inherit ACTIVE '/dev/share_vg/voting3' [200.00 MB] inherit ACTIVE '/dev/data_vg/acct_tbs_01' [1.00 GB] inherit ACTIVE '/dev/data_vg/acct_tbs_02' [1.00 GB] inherit ACTIVE '/dev/data_vg/acct_index_01' [1.00 GB] inherit ACTIVE '/dev/data_vg/acct_index_02' [1.00 GB] inherit ACTIVE '/dev/data_vg/undotbs3' [500.00 MB] inherit ACTIVE '/dev/data_vg/redo3_1' [100.00 MB] inherit ACTIVE '/dev/data_vg/redo3_2' [100.00 MB] inherit ACTIVE '/dev/data_vg/redo3_3' [100.00 MB] inherit ACTIVE '/dev/data_vg/redo3_4' [100.00 MB] inherit ACTIVE '/dev/system_vg/system' [1000.00 MB] inherit ACTIVE '/dev/system_vg/sysaux' [1000.00 MB] inherit ACTIVE '/dev/system_vg/undotbs1' [500.00 MB] inherit ACTIVE '/dev/system_vg/undotbs2' [500.00 MB] inherit ACTIVE '/dev/system_vg/temp' [500.00 MB] inherit ACTIVE '/dev/system_vg/control1' [100.00 MB] inherit ACTIVE '/dev/system_vg/control2' [100.00 MB] inherit ACTIVE '/dev/system_vg/control3' [100.00 MB] inherit ACTIVE '/dev/system_vg/redo1_1' [100.00 MB] inherit ACTIVE '/dev/system_vg/redo1_2' [100.00 MB] inherit ACTIVE '/dev/system_vg/redo1_3' [100.00 MB] inherit ACTIVE '/dev/system_vg/redo1_4' [100.00 MB] inherit ACTIVE '/dev/system_vg/redo2_1' [100.00 MB] inherit ACTIVE '/dev/system_vg/redo2_2' [100.00 MB] inherit ACTIVE '/dev/system_vg/redo2_3' [100.00 MB] inherit ACTIVE '/dev/system_vg/redo2_4' [100.00 MB] inherit ACTIVE '/dev/system_vg/users' [100.00 MB] inherit ACTIVE '/dev/system_vg/spfile' [12.00 MB] inherit ACTIVE '/dev/system_vg/pwdfile' [12.00 MB] inherit ACTIVE '/dev/VolGroup00/LogVol00' [15.53 GB] inherit ACTIVE '/dev/VolGroup00/LogVol01' [4.34 GB] inherit [iyunv@nmacct2 ~]# lvs LV VG Attr LSize Origin Snap% Move Log Copy% Convert LogVol00 VolGroup00 -wi-ao 15.53G LogVol01 VolGroup00 -wi-ao 4.34G acct_index_01 data_vg -wi-ao 1.00G acct_index_02 data_vg -wi-a- 1.00G acct_tbs_01 data_vg -wi-ao 1.00G acct_tbs_02 data_vg -wi-a- 1.00G redo3_1 data_vg -wi-a- 100.00M redo3_2 data_vg -wi-a- 100.00M redo3_3 data_vg -wi-a- 100.00M redo3_4 data_vg -wi-a- 100.00M undotbs3 data_vg -wi-a- 500.00M ocr1 share_vg -wi-ao 200.00M ocr2 share_vg -wi-ao 200.00M voting1 share_vg -wi-ao 200.00M voting2 share_vg -wi-ao 200.00M voting3 share_vg -wi-ao 200.00M control1 system_vg -wi-ao 100.00M control2 system_vg -wi-ao 100.00M control3 system_vg -wi-ao 100.00M pwdfile system_vg -wi-a- 12.00M redo1_1 system_vg -wi-ao 100.00M redo1_2 system_vg -wi-ao 100.00M redo1_3 system_vg -wi-ao 100.00M redo1_4 system_vg -wi-ao 100.00M redo2_1 system_vg -wi-ao 100.00M redo2_2 system_vg -wi-ao 100.00M redo2_3 system_vg -wi-ao 100.00M redo2_4 system_vg -wi-ao 100.00M spfile system_vg -wi-a- 12.00M sysaux system_vg -wi-ao 1000.00M system system_vg -wi-ao 1000.00M temp system_vg -wi-ao 500.00M undotbs1 system_vg -wi-ao 500.00M undotbs2 system_vg -wi-ao 500.00M users system_vg -wi-ao 100.00M 9.1.3. 绑定裸设备 (所有节点都需要操作)[iyunv@nmacct3 ~]# vi /etc/sysconfig/rawdevices # raw device bindings # format: # # example: /dev/raw/raw1 /dev/sda1 # /dev/raw/raw2 8 5 /dev/raw/raw1 /dev/share_vg/ocr1 /dev/raw/raw2 /dev/share_vg/ocr2 /dev/raw/raw3 /dev/share_vg/voting1 /dev/raw/raw4 /dev/share_vg/voting2 /dev/raw/raw5 /dev/share_vg/voting3 /dev/raw/raw6 /dev/data_vg/acct_tbs_01 /dev/raw/raw7 /dev/data_vg/acct_tbs_02 /dev/raw/raw8 /dev/data_vg/acct_index_01 /dev/raw/raw9 /dev/data_vg/acct_index_02 /dev/raw/raw10 /dev/system_vg/system /dev/raw/raw11 /dev/system_vg/sysaux /dev/raw/raw12 /dev/system_vg/undotbs1 /dev/raw/raw13 /dev/system_vg/undotbs2 /dev/raw/raw14 /dev/system_vg/temp /dev/raw/raw15 /dev/system_vg/control1 /dev/raw/raw16 /dev/system_vg/control2 /dev/raw/raw17 /dev/system_vg/control3 /dev/raw/raw18 /dev/system_vg/redo1_1 /dev/raw/raw19 /dev/system_vg/redo1_2 /dev/raw/raw20 /dev/system_vg/redo1_3 /dev/raw/raw21 /dev/system_vg/redo1_4 /dev/raw/raw22 /dev/system_vg/redo2_1 /dev/raw/raw23 /dev/system_vg/redo2_2 /dev/raw/raw24 /dev/system_vg/redo2_3 /dev/raw/raw25 /dev/system_vg/redo2_4 /dev/raw/raw26 /dev/system_vg/users /dev/raw/raw27 /dev/system_vg/spfile /dev/raw/raw28 /dev/system_vg/pwdfile /dev/raw/raw29 /dev/data_vg/undotbs3 /dev/raw/raw30 /dev/data_vg/redo3_1 /dev/raw/raw31 /dev/data_vg/redo3_2 /dev/raw/raw32 /dev/data_vg/redo3_3 /dev/raw/raw33 /dev/data_vg/redo3_4 [iyunv@nmacct3 ~]# service rawdevices restart Assigning devices: /dev/raw/raw1 --> /dev/share_vg/ocr1 /dev/raw/raw1: bound to major 252, minor 2 /dev/raw/raw2 --> /dev/share_vg/ocr2 /dev/raw/raw2: bound to major 252, minor 3 /dev/raw/raw3 --> /dev/share_vg/voting1 /dev/raw/raw3: bound to major 252, minor 4 /dev/raw/raw4 --> /dev/share_vg/voting2 /dev/raw/raw4: bound to major 252, minor 5 /dev/raw/raw5 --> /dev/share_vg/voting3 /dev/raw/raw5: bound to major 252, minor 6 /dev/raw/raw6 --> /dev/data_vg/acct_tbs_01 /dev/raw/raw6: bound to major 252, minor 7 /dev/raw/raw7 --> /dev/data_vg/acct_tbs_02 /dev/raw/raw7: bound to major 252, minor 8 /dev/raw/raw8 --> /dev/data_vg/acct_index_01 /dev/raw/raw8: bound to major 252, minor 9 /dev/raw/raw9 --> /dev/data_vg/acct_index_02 /dev/raw/raw9: bound to major 252, minor 10 /dev/raw/raw10 --> /dev/system_vg/system /dev/raw/raw10: bound to major 252, minor 11 /dev/raw/raw11 --> /dev/system_vg/sysaux /dev/raw/raw11: bound to major 252, minor 12 /dev/raw/raw12 --> /dev/system_vg/undotbs1 /dev/raw/raw12: bound to major 252, minor 13 /dev/raw/raw13 --> /dev/system_vg/undotbs2 /dev/raw/raw13: bound to major 252, minor 14 /dev/raw/raw14 --> /dev/system_vg/temp /dev/raw/raw14: bound to major 252, minor 15 /dev/raw/raw15 --> /dev/system_vg/control1 /dev/raw/raw15: bound to major 252, minor 16 /dev/raw/raw16 --> /dev/system_vg/control2 /dev/raw/raw16: bound to major 252, minor 17 /dev/raw/raw17 --> /dev/system_vg/control3 /dev/raw/raw17: bound to major 252, minor 18 /dev/raw/raw18 --> /dev/system_vg/redo1_1 /dev/raw/raw18: bound to major 252, minor 19 /dev/raw/raw19 --> /dev/system_vg/redo1_2 /dev/raw/raw19: bound to major 252, minor 20 /dev/raw/raw20 --> /dev/system_vg/redo1_3 /dev/raw/raw20: bound to major 252, minor 21 /dev/raw/raw21 --> /dev/system_vg/redo1_4 /dev/raw/raw21: bound to major 252, minor 22 /dev/raw/raw22 --> /dev/system_vg/redo2_1 /dev/raw/raw22: bound to major 252, minor 23 /dev/raw/raw23 --> /dev/system_vg/redo2_2 /dev/raw/raw23: bound to major 252, minor 24 /dev/raw/raw24 --> /dev/system_vg/redo2_3 /dev/raw/raw24: bound to major 252, minor 25 /dev/raw/raw25 --> /dev/system_vg/redo2_4 /dev/raw/raw25: bound to major 252, minor 26 /dev/raw/raw26 --> /dev/system_vg/users /dev/raw/raw26: bound to major 252, minor 27 /dev/raw/raw27 --> /dev/system_vg/spfile /dev/raw/raw27: bound to major 252, minor 28 /dev/raw/raw28 --> /dev/system_vg/pwdfile /dev/raw/raw28: bound to major 252, minor 29 /dev/raw/raw29 --> /dev/data_vg/undotbs3 /dev/raw/raw29: bound to major 252, minor 30 /dev/raw/raw30 --> /dev/data_vg/redo3_1 /dev/raw/raw30: bound to major 252, minor 31 /dev/raw/raw31 --> /dev/data_vg/redo3_2 /dev/raw/raw31: bound to major 252, minor 32 /dev/raw/raw32 --> /dev/data_vg/redo3_3 /dev/raw/raw32: bound to major 252, minor 33 /dev/raw/raw33 --> /dev/data_vg/redo3_4 /dev/raw/raw33: bound to major 252, minor 34 done 9.1.4. 修改裸设备权限? 原有节点,修改新增的5个裸设备权限chown oracle:dba /dev/raw/raw29 chown oracle:dba /dev/raw/raw30 chown oracle:dba /dev/raw/raw31 chown oracle:dba /dev/raw/raw32 chown oracle:dba /dev/raw/raw33 chmod 660 /dev/raw/raw29 chmod 660 /dev/raw/raw30 chmod 660 /dev/raw/raw31 chmod 660 /dev/raw/raw32 chmod 660 /dev/raw/raw33 ? 新节点,修改所有裸设备权限[iyunv@nmacct3 raw]# chown oracle:dba /dev/raw/raw* [iyunv@nmacct3 raw]# chmod 660 /dev/raw/raw* 9.1.5. 修改启动文件使权限永久生效[iyunv@nmacct3 raw]# vi /etc/rc.local #!/bin/sh # # This script will be executed *after* all the other init scripts. # You can put your own initialization stuff in here if you don't # want to do the full Sys V style init stuff. touch /var/lock/subsys/local chown oracle:dba /dev/raw/* chmod 660 /dev/raw/* 9.2. 删除authorized_keys文件中删除节点的信息[oracle@nmacct1 ~]$ more ~/.ssh/authorized_keys ssh-dss AAAAB3NzaC1kc3MAAACBANOunki5oT8vq744Uz2xmokrt8r1cZ32e0myFQgYvaUUY3P/vg5GaQ9w/VC4hDaPeTY/vI88wNCunJYuY5DYxs4YvFXLoByPk7pZLYPT6zZgGraeW7rKyT09H/SkqCJW59/xqOz89uI BILvkTEJde/n/7Ge7y0Wf85upk4651ylBAAAAFQCidCWpkJ80TCs4LmtvVaOuuLpvKQAAAIBXAUqBwTX1LjJhPPPLql+t7+ac0CVUOW6/1AF4l/palndYm1U3CC80A0cVoVOJui5pg4ruht4Gtj23X7yjKxMXARL/tf5/bG C7k/+Dk+1F0yTIyNQAgQNaqxeQD02+Ft4rTIRyVuOg1StJ5/oBQpRAMVVPY8K6RkiBZElap8NxlQAAAIBcFPPdoG9faIZK7GWdUCePctTdiCbMCTlTBZ1ZQBzEDznOqplEg/FiEkUpwyLwe2+2Atpj7lPxPcw4usMAc0nrM AplaYnCNjnYS1GDSn5qNEd6lG+87NrDT/8elRRhoytX7efXj4yrKfnjLr4FH+I+pPflVeJPOJAQlLBaulbVTg== oracle@nmacct1 ssh-rsa AAAAB3NzaC1yc2EAAAABIwAAAQEA1mpki84dmcxKdsFwjumkDql0xh4CnPAYrHvWIk7LVRPU1s6Wog9TD5u7L4Lh0Lqb2EWbMQZ195viCddWMRr+tc+qZv+F23hOakH/HF3ikb5sxqGBFdPPQ/nBL/GbBUrbAIo 62APEFOeqpj1vUGMT295mFaeSzlH3vVsLStwxKb4tFyqW7S91MsdZ61QQeWydvTMl5mam+vCsyLSij75gVHC/QSbDGKTEuMntOwLFBXTbf+A7BA4Ml8/PwDd8KzdgD/eMBu2+YDX5lPLagZ8HYDiqJ6bsHDgZzZ8ZWIt3z6 hIGAZbHF4oRK+6w+IgjsIT2/K2rKIvFTpvbqKeE/mCSw== oracle@nmacct1 ssh-dss AAAAB3NzaC1kc3MAAACBAJKaAZnkGVodW/OfzMON9HNPVxsGUnDu5tTGYFaKCf90yc7l96ca4vu7xzv7M3HGqeQJLqRHvk9Hkv6Oxt3eLYhhH4rIdRocIVtEdMfaA/MVhmtMT5XLo/M/DhKBEBP+A+JoNVbtBQa XoFmpc+8tu7EK2zdldWVCOPhMjsKtNr23AAAAFQCsEWeVTKty3JqaB2aA4DsgSDNF4QAAAIEAgyzlNhoH+nasgBzPT3OhqQHJY4uG8KSGTlJrg0MB5owT/pv7FKtxTxAot8ScpLorR2RS0Czomo87EBD/Y+5XJnl9dCWY9n 0t3yo5c1XtiO/XpDS87c9rECReIH+ts2wzuYyUHbueTk2w0USvDICX1Fw+TvVd/iazKEs7PxPAyxEAAACAA8vKxGJJQu6IW9kssuXQ9kvNUOhIsswieNH9DcgQ++Ai5zS5bjYRFjVdn0CwV+lca97HdE1CTw3EYH/MAcA0h ws5LxruoXr1eKVja9d2oU+1CrwGT2ZuuKPZcBO09ks3a0PVdgE+LT8JWTmVxUgvEZS5cyHnZCmmEiRYwwmTNNI= oracle@nmacct2 ssh-rsa AAAAB3NzaC1yc2EAAAABIwAAAQEAstMGJ9yhTRy0Z7Wcc8Va5ymyp1c2BtlS4GH98HW77xdXtCQcdKjpduVkMi/uqqf3VsnHIe5MXCi+bbxyfJ8hjm5JIBttSrdRyUpmzTHtxhTE1xt7u86tRdJL4GYwP+xrg4I 0Byerc+JkqwBqLXJ1niakGY8fkaBUzd3pu1vzPG+PsITr9VlUX0M4+c5lZquQthmeiHeMfE7eKAd6vY32+5V0YPeOT2eJtQcJ1AYJjHnIaoeKj9cCl2roU5mR7IfTMPvjeZpPfUYR1n6hKXbE9mmoFHpsUnnd1ALbqqXtMr SxqQ143siqhSn/d0JWFQ7JG9yfspqoJfWNqZhWhigX8w== oracle@nmacct2 ssh-dss AAAAB3NzaC1kc3MAAACBAKsKzV46HSJScGHq3k7LXSsugmOFfhvVWgXHOH7CmPRwPG78zcYHup9YzrUFJbzIw95QE61vlM8ch8cqg7nRBWQ2KeP74szfztw/wQJBKAsJBQZhsJs+sdRpqO0haRXvrUgc6a1heWp jq0Lnu7yMw5tNEa7GOUmnilBYXsHqkKOZAAAAFQDMbbLlNf5Cfk2/SuY4TSPrRMeqeQAAAIBXho6w2PsPz9cDsjXpQlh0W8Wel45ZuQ30WxX++CGcbceVBsbZeeu8JZE84IOuGLlYoDghHjgVm9eS0Qmve1tKHkftXD/Sf3 D6aBwu1ow/ORWXl1BoqKRl72cE0qyqfyZ2BMA7Qj25fBqi9gvNn3WNtg3MPzWtoVvGULT86EvRTwAAAIBXkC9FIbUA1+GxLXkXG+zq/20DgMJ/Z6MmuFwuwoDWrEn3DOiCidlvsRqvv0ssBYQPLp7UbPW+9ykXJQ/NfFlTo BbZ0JDIpy4pYmwZw67mKjAm3sPTOW3aDW5DOUzeYYBiGmZwl9QxeIxmyzJsNvrfTokLUQ8ynMsF2PYJFwb3lQ== oracle@nmacct3 ssh-rsa AAAAB3NzaC1yc2EAAAABIwAAAQEA3Veetu3/rltqNuZ67mQFOJ1rRPnFCUf/tkSP9GbsleEZUHe6iCz7O7W0RY+hbU1shSJ6o4w9hBx0TKeh7bCoX+s3iFQVw1JhDgMcI5beIORBn1R1fO4vpTvGMJ5PN+zSwxQ VKBrRamhttJoGGM0zQtrT3b4gng5Ww1Q2TlQHipU8H1pNTYE6UsMUg5Qb4Vn3QsaZKFfFzByrkvSO/PQZSnGW3ZQ8tHilXUpfcwk9v7c6FFd0MVTlcZ4mVqtX7hBvmTWG4IixPjJsFmH8a+WNMnjud4vII9Px3YHlzbyX2q /SYpht0BI9JCbMbV6uh7woyiYhjtKXxd83ysgR/trW7Q== oracle@nmacct3

|